Dell Intel PRO Family of Adapters Guía del usuario

- Categoría

- Tarjetas de redes

- Tipo

- Guía del usuario

Adaptadores y dispositivos Intel

®

Ethernet

Guía del usuario

Visión general

Bienvenidos a la Guía del usuario de los adaptadores y dispositivos Intel® Ethernet. Este manual describe la

instalación del hardware y software, los procedimientos de configuración y pautas para la resolución de problemas

para los adaptadores de red Intel, conexiones y otros dispositivos.

Instalación del adaptador de red

Si está instalando un adaptador de red, siga este procedimiento desde el paso 1.

Si está actualizando el software del controlador, empiece con el paso 4.

NOTA: si actualiza el firmware, debe actualizar el software del controlador a la versión de la misma familia.

1. Revise los requisitos del sistema.

2. Introduzca el adaptador PCI Express, la tarjeta Mezzanine o la tarjeta dependiente de red en su servidor.

3. Conecte con cuidado los cables de cobre, cables de fibra o cables de conexión directa de su red.

4. Instale los controladores de red y el resto del software.

l Instrucciones de Windows

l Instrucciones de Linux

5. Prueba del adaptador.

Destinatarios

Este documento está dirigido a profesionales de la tecnología de la información con un alto nivel de conocimiento,

experiencia y competencia en la tecnología de redes Ethernet.

Antes de comenzar

Dispositivos compatibles

Adaptadores de red 40 Gigabit compatibles

l Intel® Ethernet 40G 2P XL710 QSFP+ rNDC

l Adaptador de Ethernet de red convergente Intel® XL710-Q2

NOTAS:

l Los dispositivos basados en el controlador Intel Ethernet XL710 (4x10 GbE, 1x40 GbE, 2x40 GbE)

tienen un rendimiento total esperado para todo el dispositivo de 40 Gb/s en cada dirección.

l El primer puerto de los adaptadores basados en el controlador Intel® Ethernet de la serie 700 mostrará

la cadena de marca correcta. Todos los demás puertos del mismo dispositivo mostrarán una cadena de

marca genérica.

l Para que un adaptador basado en el controlador Intel® Ethernet de la serie 700 alcance su pleno

potencial, debe instalarlo en una ranura PCIe Gen3 x8. Si se instala en una ranura más corta, o en una

ranura Gen2 o Gen1, el rendimiento del adaptador se verá limitado.

Adaptadores de red 25 Gigabit compatibles

l Intel® Ethernet 25G 2P XXV710 Mezz

l Adaptador Intel® Ethernet 25G 2P XXV710

NOTAS:

l Los dispositivos basados en el controlador Intel Ethernet XXV710 (2x25 GbE) tienen un límite total de

rendimiento de hardware para todo el dispositivo de ~96-97 % de la velocidad de línea de 25 GbE de

doble puerto en cada dirección para paquetes grandes de TCP IPv4 (>1518 bytes) con un tamaño de

MTU de 1500 bytes. Por ejemplo, el rendimiento total de la carga se limita a ~45,5 Gb/s en cada

dirección. Por lo tanto, aunque el rendimiento de 25 GbE de un solo puerto no se ve afectado, se espera

que el rendimiento total simultáneo de 25 GbE del doble puerto sea ligeramente inferior al de la

velocidad de línea.

El primer puerto de los adaptadores basados en el controlador Intel® Ethernet de la serie 700 mostrará

la cadena de marca correcta. Todos los demás puertos del mismo dispositivo mostrarán una cadena de

marca genérica.

Adaptadores de red 10 Gigabit compatibles

l Adaptador Intel® Ethernet 10G 2P X520

l Intel® Ethernet 10G X520 LOM

l Intel® Ethernet X520 10GbE KX4-KR Mezz de doble puerto

l Adaptador Intel® Ethernet 10G 2P X540-t

l Adaptador Intel® Ethernet 10G 2P X550-t

l Intel® Ethernet 10G 4P X550 rNDC

l Intel® Ethernet 10G 4P X550/I350 rNDC

l Intel® Ethernet 10G 4P X540/I350 rNDC

l Intel® Ethernet 10G 4P X520/I350 rNDC

l Intel® Ethernet 10G 2P X520-k bNDC

l Intel® Ethernet 10G 4P X710-k bNDC

l Intel® Ethernet 10G 2P X710-k bNDC

l Intel® Ethernet 10G X710-k bNDC

l Adaptador de Ethernet de red convergente Intel® X710

l Adaptador de Ethernet de red convergente Intel® X710-T

l Intel® Ethernet 10G 4P X710/l350 rNDC

l Intel® Ethernet 10G 4P X710 SFP+ rNDC

l Intel® Ethernet 10G X710 rNDC

l Intel® Ethernet Server Adapter X710-DA2 para OCP para servidores

l Intel® Ethernet 10G 2P X710 OCP

l Intel® Ethernet 10G 4P X710 OCP

l Intel® Ethernet 10G 2P X710-T2L-t OCP

l Adaptador Intel® Ethernet 10G 2P X710-T2L-t

NOTA:

El primer puerto de los adaptadores basados en el controlador Intel® Ethernet de la serie 700 mostrará la

cadena de marca correcta. Todos los demás puertos del mismo dispositivo mostrarán una cadena de marca

genérica.

Dispositivos y adaptadores de red Gigabit compatibles

l Adaptador Intel® Gigabit 2P I350-t

l Adaptador Intel® Gigabit 4P I350-t

l Intel® Ethernet 1G 4P I350-t OCP

l Intel® Gigabit 4P X550/I350 rNDC

l Intel® Gigabit 4P I350-t rNDC

l Intel® Gigabit 4P X540/I350 rNDC

l Intel® Gigabit 4P X520/I350 rNDC

l Intel® Gigabit 4P I350-t Mezz

l Intel® Gigabit 4P X710/l350 rNDC

l Intel® Gigabit 4P I350 bNDC

l Placa posterior de conexión Intel® Ethernet I354 1.0 GbE

l Intel® Gigabit 2P I350-t LOM

l Intel® Gigabit I350-t LOM

l Intel® Gigabit 2P I350 LOM

Sistemas operativos admitidos

Sistemas operativos con arquitectura Intel® 64 compatibles

l Microsoft Windows Server 2019, versión 1903

l Microsoft Windows Server 2019

l Microsoft* Windows Server* 2016

l VMWare* ESXi* 6.7 U3

l VMWare* ESXi* 6.5 U3

l Red Hat* Enterprise Linux* (RHEL) 8.1

l Red Hat* Enterprise Linux* (RHEL) 7.7

l Novell* SUSE* Linux Enterprise Server (SLES) 15 SP1

Compatibilidad del hardware

Antes de instalar el adaptador, realice las siguientes comprobaciones en el sistema:

l El BIOS más reciente para su sistema

l Una ranura de PCI Express* abierta (consulte las especificaciones de su tarjeta para conocer las ranuras

compatibles)

Requisitos de los cables

Consulte la sección Conexión de los cables de red.

Visión general de la instalación

Instalación del adaptador

1. Apague el equipo y desconecte el cable de energía.

2. Quite la cubierta del sistema y la cubierta de la ranura del adaptador en la ranura que corresponde al

adaptador.

3. Inserte el conector del borde del adaptador en la ranura y asegure el soporte del chasis.

4. Vuelva a colocar la cubierta y conecte el cable de alimentación.

NOTA: para obtener más información sobre la identificación de ranuras PCI Express compatibles con sus

adaptadores, consulte la guía de su sistema Dell EMC.

Instalación de controladores y software

Sistemas operativos Windows*

Para poder instalar los controladores, debe tener derechos de administrador en el sistema operativo.

1. Descargue los controladores más recientes desde el sitio web de asistencia y transfiéralos al sistema.

2. Si se muestra la pantalla del asistente de detección de nuevo hardware, haga clic en Cancel (Cancelar).

3. Haga doble clic en el archivo descargado.

4. Seleccione Install (Instalar) en la pantalla del paquete de actualizaciones de Dell.

5. Siga las instrucciones del asistente de instalación. Asegúrese de seleccionar Intel PROSet para la instalación.

NOTA: asegúrese de seleccionar la opción de instalación "iSCSI using Data Center Bridging" (iSCSI con

puentes de centro de datos) para sistemas que tienen un dispositivo preparado para NPAR instalado.

Instalación de controladores de Linux* desde el código fuente

1. Descargue y expanda el archivo con la extensión tar del controlador.

2. Compile el módulo del controlador.

3. Instale el módulo con el comando modprobe.

4. Asigne una dirección IP mediante el comando ifconfig.

Instalación de controladores de Linux desde RPM

1. Descargue y expanda el archivo con la extensión tar del controlador.

2. Compile el módulo del controlador.

3. Instale el controlador con el comando rpm.

Consulte la sección de Linux de esta guía, donde encontrará información específica.

Optimización del rendimiento

Puede definir la configuración avanzada de los adaptadores de red Intel para ayudar a optimizar el rendimiento del

servidor.

En la sección Optimización general se incluyen secciones que proporcionan información acerca de los tres modelos

de uso del servidor:

l Optimizado para respuesta rápida y baja latencia: útil para servidores de vídeo, audio y con clúster de cálculo

de alto rendimiento (HPCC)

l Optimizado para rendimiento: útil para servidores de archivos y de copia de seguridad y recuperación de datos

l Optimizado para utilización de la CPU: útil para servidores de aplicaciones, web, correo y bases de datos

NOTAS:

l Los usuarios de Linux deberán consultar la sección sobre Linux de esta guía y el archivo LÉAME del

paquete de controlador de Linux para ver los detalles de mejora del rendimiento específicos de Linux.

l Las recomendaciones que se indican a continuación son pautas y deben ser tratadas como tales. Hay

más factores, como las aplicaciones instaladas, el tipo de bus, la topología de la red y el sistema

operativo, que también afectan el rendimiento del sistema.

l Estos ajustes los debe realizar un administrador de red con sólida experiencia. No se garantiza que

estos mejoren el rendimiento. Todos los ajustes que se muestran aquí pueden no estar disponibles

mediante la configuración del controlador de red, el sistema operativo o la configuración del BIOS del

sistema.

l Al utilizar software de prueba de rendimiento, consulte la documentación de la aplicación para obtener

resultados óptimos.

Optimización general

l Instale el adaptador en una ranura adecuada.

NOTA: algunas ranuras PCIe x8 están configuradas en realidad como ranuras x4. Estas ranuras tienen

un ancho de banda insuficiente para la velocidad de línea entera con algunos dispositivos de doble

puerto. El controlador puede detectar esta situación y escribirá el mensaje siguiente en el registro del

sistema: "PCI Express bandwidth available for this card is not sufficient for optimal performance" (El

ancho de banda de PCI Express disponible para esta tarjeta no es suficiente para conseguir un

rendimiento óptimo). "For optimal performance a x8 PCI-Express slot is required." (Para conseguir un

rendimiento óptimo es necesaria una ranura x8 PCI-Express). Si se produce este error, traslade el

adaptador a una ranura x8 verdadera para solucionar el problema.

l Para que un adaptador de red de la serie 710 de Intel® alcance su pleno potencial, debe instalarlo en una

ranura PCIe Gen3 x8. Si se instala en una ranura más corta, o en una ranura Gen2 o Gen1, el rendimiento del

adaptador se verá limitado.

l Utilice el cableado adecuado para su dispositivo.

l Aumente el número de recursos de TCP y de zócalo a partir del valor predeterminado. Para los sistemas

basados en Windows, no hemos identificado parámetros de sistema, además del tamaño de ventana TCP, que

afecten significativamente el rendimiento.

l Aumente el tamaño de asignación de recursos del controlador (búferes de transmisión y recepción). Sin

embargo, la mayoría de los patrones de tráfico TCP funcionan mejor cuando el búfer de transmisión se

establece en el valor predeterminado y el búfer de recepción se establece en el valor mínimo.

Tramas jumbo

La habilitación de las tramas jumbo puede aumentar el rendimiento. Debe habilitar las tramas jumbo en todos los

componentes de red para poder aprovechar las ventajas.

Colas de RSS

Si cuenta con varios puertos de 10 Gpbs (o más rápidos) instalados en un sistema, las colas RSS de cada puerto de

adaptador pueden ajustarse para utilizar conjuntos de procesadores no superpuestos dentro del Nodo/Zócalo de

NUMA local del adaptador. Cambie el número de procesador base de RSS para cada puerto de adaptador, de

manera que la combinación del procesador base y el número máximo de la configuración de los procesadores RSS

garanticen que no se solapen los núcleos. Para sistemas Microsoft Windows, haga lo siguiente:

1. Identifique los puertos de adaptador para ajustar e inspeccione RssProcessorArray utilizando el cmdlet Get-

NetAdapterRSS de PowerShell.

2. Identifique los procesadores con distancias 0 NUMA. Estos son los núcleos en el Nodo/Zócalo de NUMA local

del adaptador y proporcionarán el mejor rendimiento.

3. Ajuste el procesador base de RSS en cada puerto para utilizar un conjunto de procesadores no superpuestos

dentro del conjunto de procesadores locales. Puede hacerlo manualmente o utilizando el siguiente comando

de PowerShell:

Set-NetAdapterAdvancedProperty -Name <Nombre de adaptador> -DisplayName "RSS Base

Processor Number" -DisplayValue <Valor de procesador base de RSS>

4. Utilice el cmdlet Get-NetAdapterAdvancedproperty para comprobar que se han configurado los valores

correctos:

Get-NetAdapterAdvancedproperty -Name <nombre del adaptador>

Por ejemplo: para un adaptador de 4 puertos con los procesadores locales 0, 2, 4, 6, 8, 10, 12, 14, 16, 18, 20, 22, 24,

26, 28, 30, y 'Max RSS processor' de 8, establezca los procesadores de base de RSS en 0, 8, 16 y 24.

Afinidad de la CPU

Al transmitir el tráfico por varios puertos de red utilizando una aplicación E/S que se ejecuta en la mayoría o en todos

los núcleos de su sistema, puede establecer la afinidad de CPU para esa aplicación con menos núcleos. Esto debería

reducir la utilización de la CPU y, en algunos casos, puede aumentar el rendimiento del dispositivo. Los núcleos

seleccionados para la afinidad de CPU deben ser locales para el procesador Nodo/Grupo del dispositivo de red

afectado. Puede utilizar el comando de PowerShell Get-NetAdapterRSS para enumerar los núcleos que son locales

para un dispositivo. Puede que sea necesario aumentar el número de núcleos asignados a la aplicación para

maximizar el rendimiento. Consulte la documentación de su sistema operativo para obtener más detalles sobre la

configuración de la afinidad de CPU.

Optimizado para respuesta rápida y baja latencia

l Minimice o deshabilite la tasa de moderación de interrupciones.

l Deshabilite la descarga de segmentación TCP.

l Deshabilite los paquetes jumbo.

l Aumente los descriptores de transmisión.

l Aumente los descriptores de recepción.

l Aumente las colas de RSS.

Optimizado para rendimiento

l Active los paquetes jumbo.

l Aumente los descriptores de transmisión.

l Aumente los descriptores de recepción.

l En los sistemas compatibles con NUMA, establezca el nodo NUMA preferido en cada adaptador para

conseguir un mejor escalado entre nodos NUMA.

Optimizado para utilización de la CPU

l Maximice la tasa de moderación de interrupciones.

l Conserve el valor predeterminado para el número de descriptores de recepción; evite establecer números

grandes de descriptores de recepción.

l Reduzca las colas de RSS.

l En entornos Hyper-V, reduzca el número máximo de CPU de RSS.

Almacenamiento remoto

Las funciones de almacenamiento remoto permiten acceder a SAN o a otros sistemas de almacenamiento en red

utilizando protocolos Ethernet. Esto incluye Data Center Bridging (DCB) e iSCSI sobre DCB.

DCB (Puentes de centro de datos)

La Habilitación de puentes de centro de datos (DCB) es un conjunto de ampliaciones basadas en estándares de la

Ethernet clásica. Proporciona una capa de transporte de centro de datos sin pérdidas que permite la convergencia de

las LAN y las SAN en una infraestructura unificada única.

Además, DCB es una implementación de calidad de servicio de configuración en el hardware. Utiliza la etiqueta de

prioridad VLAN (802.1p) para filtrar el tráfico. Esto significa que hay 8 prioridades diferentes con las que se puede

filtrar el tráfico. También permite un control de flujo prioritario (802.1Qbb) que puede limitar o eliminar la pérdida de

paquetes durante los momentos de mayor uso de la red. Se puede asignar un ancho de banda a cada una de estas

prioridades, que se aplica en el nivel de hardware (802.1Qaz).

El firmware del adaptador implementa los agentes de los protocolos LLDP y DCBX de acuerdo con 802.1AB y

802.1Qaz, respectivamente.

Consulte "DCB (Habilitación de puentes de centro de datos) para conexiones de red Intel®" en la página 117 si desea

obtener más información.

NOTA: en dispositivos basados en X710 que utilizan Microsoft Windows, los puentes de centro de datos (DCB)

solo son compatibles con la versión del firmware 17.0.12 y versiones posteriores. Las versiones de NVM

anteriores se deben actualizar para que el adaptador pueda usar DCB en Windows.

Dispositivos compatibles

Todos los dispositivos con capacidad de 10 GbE o más rápidos admiten DCB.

NOTA: Cuando un dispositivo está en modo NPar, solo puede configurar DCB mediante la Configuración del

sistema/BIOS.

iSCSI en DCB

Los adaptadores Intel® Ethernet son compatibles con los iniciadores de software iSCSI nativos del sistema operativo

subyacente. Los adaptadores basados en Intel® 82599 y X540 son compatibles con iSCSI en una nube de

habilitación de puentes de centro de datos (DCB). Si se utiliza junto con conmutadores y destinos que admitan la

aplicación TLV de iSCSI/DCB, esta solución puede proporcionar un ancho de banda mínimo garantizado para el

tráfico iSCSI entre el host y el destino. Esta solución permite a los administradores de almacenamiento segmentar el

tráfico iSCSI y distinguirlo del tráfico LAN. Anteriormente, el proveedor de conmutadores trataba como tráfico LAN el

tráfico iSCSI dentro de un entorno compatible con DCB. Consulte a sus proveedores de conmutador y de destino si

son compatibles con la aplicación TLV de iSCSI/DCB.

Arranque remoto

El arranque remoto permite arrancar un sistema solo con un adaptador de Ethernet. Puede conectarse a un servidor

que contenga una imagen del sistema operativo y utilizarlo para arrancar su sistema local.

Intel

®

Boot Agent

Intel® Boot Agent es un producto de software que permite a los equipos conectados en una red iniciarse por medio de

una imagen de código de programa suministrada por un servidor remoto. Intel Boot Agent se ajusta a la especificación

de Pre-boot eXecution Environment (PXE), versión 2.1. Es compatible con los entornos legados de Boot Agent que

utilizan el protocolo BOOTP.

Dispositivos compatibles

Para todos los dispositivos compatibles con esta versión, PXE se habilita a través del entorno de uEFI (interfaz HII).

Bootutil se puede utilizar para cambiar las opciones de arranque remoto cuando el servidor se establece en modo de

arranque heredado en el BIOS. Si se arranca en modo EFI, el BIOS del servidor gestionará los cambios del modo de

arranque. Bootutil no se puede utilizar para actualizar la imagen de arranque del dispositivo. La actualización del

adaptador se gestiona a través del correspondiente paquete de actualización de Dell.

Arranque iSCSI de Ethernet Intel

®

Arranque iSCSI de Ethernet Intel® ofrece la función de iniciar un sistema cliente desde un volumen de disco iSCSI

remoto ubicado en una red de área de almacenamiento (SAN) basada en iSCSI.

Dispositivos compatibles

l Adaptador Intel® Gigabit 2P I350-t

l Adaptador Intel® Gigabit 4P I350-t

l Intel® Gigabit 4P I350-t rNDC

l Intel® Gigabit 4P I350 bNDC

l Intel® Gigabit 2P I350-t LOM

l Intel® Gigabit I350-t LOM

l Intel® Gigabit 2P I350 LOM

l Intel® Gigabit 4P I350-t Mezz

l Intel® Ethernet 1G 4P I350-t OCP

l Intel® Ethernet X520 10GbE KX4-KR Mezz de doble puerto

l Adaptador Intel® Ethernet 10G 2P X520

l Intel® Ethernet 10G 2P X520-k bNDC

l Intel® Ethernet 10G X520 LOM

l Intel® Ethernet 4P X520/I350 rNDC

l Adaptador Intel® Ethernet 10G 2P X540-t

l Intel® Ethernet 10G 4P X540/I350 rNDC

l Adaptador Intel® Ethernet 10G 2P X550-t

l Adaptador de Ethernet de red convergente Intel® XL710-Q2

l Intel® Ethernet 10G 4P X550 rNDC

l Intel® Ethernet 10G 4P X550/I350 rNDC

l Adaptador de Ethernet de red convergente Intel® X710

l Intel® Ethernet 10G 2P X710 OCP

l Intel® Ethernet 10G 2P X710-k bNDC

l Intel® Ethernet 10G 4P X710-k bNDC

l Intel® Ethernet 10G X710-k bNDC

l Intel® Ethernet 10G 4P X710/l350 rNDC

l Intel® Ethernet 10G 4P X710 SFP+ rNDC

l Intel® Ethernet 10G X710 rNDC

l Adaptador de red convergente Intel® X710-T

l Adaptador de Ethernet Intel® X710-DA2 para OCP para servidores

l Adaptador Intel® Ethernet 25G 2P XXV710

l Intel® Ethernet 25G 2P XXV710 Mezz

l Intel® Ethernet 40G 2P XL710 QSFP+ rNDC

Soporte para virtualización

La virtualización hace posible que uno o varios sistemas operativos se ejecuten de manera simultánea en el mismo

sistema físico como máquinas virtuales. Esto le permite consolidar varios servidores en un solo sistema, aunque

funcionen con sistemas operativos distintos. Los adaptadores de red Intel® funcionan con y dentro de máquinas

virtuales con sus controladores y software estándar.

NOTAS:

l Algunas opciones de virtualización no están disponibles en algunas combinaciones de

adaptador/sistema operativo.

l La configuración de tramas jumbo en una máquina virtual debe ser la misma o inferior a la

configuración en el puerto físico.

l Si se conecta una máquina virtual a una red superpuesta inquilina a través de puertos NIC virtuales en

un conmutador virtual, los colectores de encapsulación aumentan el tamaño de la unidad de

transmisión máxima (MTU) del puerto virtual. La función de sobrecarga de encapsulación ajusta

automáticamente el tamaño de la MTU del puerto físico para compensar este aumento.

Utilización de adaptadores de red Intel

®

en un entorno Microsoft* Hyper-V*

Cuando se crea una interfaz NIC virtual (VNIC) de Hyper-V en el SO host, la VNIC toma la dirección MAC de la NIC

física subyacente (PF o función física). Dado que la VNIC utiliza la dirección MAC de la interfaz subyacente, cualquier

operación que cambie la dirección MAC de la interfaz (por ejemplo, definir LAA en la interfaz), causará una pérdida de

conectividad de la VNIC. Para prevenir esta pérdida de conectividad, Intel® PROSet no le permitirá cambiar

configuraciones que modifiquen la dirección MAC.

NOTAS:

l Cuando se envían desde dentro de una máquina virtual, los paquetes LLDP y LACP pueden ser un

riesgo para la seguridad. El controlador de la función Intel® virtual bloquea la transmisión de tales

paquetes.

l El ajuste Virtualización de la ficha Avanzado de la hoja de propiedades del Administrador de

dispositivos relativas al adaptador no está disponible si no está instalado el rol Hyper-V.

l Antes de configurar las funciones de Microsoft* Hyper-V, el paquete de actualizaciones de Dell EMC

debe haber instalado los controladores NIC de Intel®. Si la función Microsoft* Hyper-V está configurada

en una partición NIC no admitida en un dispositivo X710 de Intel® antes de usar el paquete de

actualizaciones de Dell EMC para instalar los controladores NIC de Intel®, puede que la instalación del

controlador no se complete. Para realizar la recuperación, debe desinstalar Microsoft* Hyper-V,

desinstalar "Conexiones de red Intel®" de "Programas y características" y usar el paquete de

actualizaciones de Dell EMC para instalar los controladores NIC de Intel®.

Conmutador de máquina virtual

El conmutador de máquina virtual forma parte de la ruta de datos de E/S de la red. Se encuentra entre la NIC física y

las NIC de máquina virtual y direcciona paquetes a la dirección MAC correcta. Al habilitar la descarga de cola de

máquina virtual (VMQ) en Intel® PROSet se habilitará VMQ automáticamente en el conmutador de máquina virtual. En

el caso de instalaciones solo de controlador, debe habilitar manualmente VMQ en el conmutador de máquina virtual.

Descarga de la cola de máquina virtual

La habilitación de la descarga de VMQ aumenta el desempeño de recepción y transmisión, ya que el adaptador es

capaz de realizar dichas tareas de forma más rápida que el sistema operativo. La descarga también libera recursos de

CPU. El proceso de filtrado se basa en los filtros de MAC y/o VLAN. Para los dispositivos compatibles, la descarga de

VMQ está habilitada en la partición del host, en la hoja de propiedades del Administrador de dispositivos relativas al

adaptador, en la ficha Opciones avanzadas de Virtualización.

Cada adaptador Intel® Ethernet tiene un grupo de puertos virtuales divididos entre las diferentes funciones, como

descarga de VMQ, SR-IOV, y habilitación de puentes de centro de datos (DCB). Si se aumenta el número de puertos

virtuales usados para una función, disminuye el número disponible para otras. En los dispositivos que lo admiten,

activar DCB reduce el grupo disponible para otras funciones a 32.

NOTA: esto no se aplica a los dispositivos basados en los controladores Intel® Ethernet X710 o XL710.

Intel PROSet muestra el número de puertos virtuales disponibles para funciones virtuales en las propiedades de

Virtualización, en la ficha Opciones avanzadas del dispositivo. También permite configurar cómo se distribuyen los

puertos virtuales disponibles entre VMQ y SR-IOV.

Colas múltiples de máquinas virtuales

Con las colas múltiples de máquinas virtuales (VMMQ) se activa el Ajuste de escala en lado de recepción (RSS) para

los puertos virtuales conectados a un puerto físico. Esto permite utilizar RSS con SR-IOV y dentro de una máquina

virtual VMQ, y descarga el procesamiento de RSS en el adaptador de red. RSS equilibra el tráfico de recepción en

varias CPU o núcleos de CPU. Esta configuración no surte efecto si su sistema tiene una sola unidad de

procesamiento.

Descripción general de SR-IOV

La virtualización de E/S de raíz única (SR-IOV) es una especificación PCI SIG que permite a los dispositivos PCI

Express aparecer como varios dispositivos PCI Express físicos separados. SR-IOV permite compartir con eficacia

dispositivos PCI entre máquinas virtuales (VM). Administra y transporta datos sin el uso de un hipervisor

proporcionando espacio de memoria independiente, interrupciones y flujos DMA para cada máquina virtual.

La arquitectura SR-IOV incluye dos funciones:

l La función física (PF) es una función plena de PCI Express que se puede detectar, administrar y configurar

como cualquier otro dispositivo PCI Express.

l La función virtual (VF) es similar a la PF, pero no se puede configurar y solo tiene la capacidad de transferir

datos de entrada y salida. La VF se asigna a una máquina virtual.

NOTAS:

l SR-IOV debe habilitarse en la BIOS.

l Si la SR-IOV no está habilitada en la configuración del sistema F2, la disponibilidad de VPort no

aparece en el cuadro de diálogo Virtualización al instalar Intel PROSet para el Administrador de

dispositivos de Windows. Habilite la SR-IOV en el BIOS del sistema y vuelva a instalar Intel PROSet

para el Administrador de dispositivos de Windows para corregir la visualización.

l Si planea asignar dispositivos directamente a una máquina virtual en Linux, debe habilitar la

compatibilidad con la unidad de gestión de memoria de E/S para que SR-IOV funcione correctamente.

Utilice los parámetros de arranque del kernel "intel_iommu=on" para placas de sistemas con

procesadores Intel o "amd_iommu=on" para placas de sistemas con procesadores AMD, y "iommu=pt"

para habilitar la compatibilidad con IOMMU. Para obtener la mejor protección de la memoria, utilice

"intel_iommu=on". Para obtener el mejor rendimiento, utilice ambos parámetros ("intel_iommu=on

iommu=pt"). En RedHat y en la mayoría de las demás distribuciones de Linux, agregue estos

parámetros a la entrada GRUB_CMDLINE_LINUX del archivo de configuración /etc/default/grub. Para

sistemas de arranque en modo UEFI, ejecute grub2-mkconfig -o /etc/grub2-efi.cfg. Para

sistemas de arranque en modo BIOS heredados, ejecute grub2-mkconfig -o

/boot/grub2/grub.cfg. Para agregar estos parámetros en las distribuciones de Linux basadas en

SUSE, abra Yast y, a continuación, abra el cargador de arranque y haga clic en la ficha de parámetros

del kernel. Agregue los parámetros opcionales en el campo de parámetro de línea de comandos

opcional del kernel. Esto añade las opciones para cualquiera de los modos de arranque. Es necesario

reiniciar para que los cambios surtan efecto.

FW-LLDP (Firmware-Protocolo de detección de capa de enlace)

Los dispositivos basados en el controlador Intel® Ethernet serie 700 utilizan un agente de protocolo de detección de

capa de enlace (LLDP) que se ejecuta en el firmware. Cuando se está ejecutando, impide que el sistema operativo y

las aplicaciones reciban tráfico LLDP desde el adaptador de red.

l La configuración de FW-LLDP es por puerto.

l El agente FW-LLDP es necesario para que DCB funcione correctamente.

Adaptadores basados en el controlador Intel® Ethernet serie 700

FW-LLDP está habilitado en NVM de forma predeterminada. Para habilitar/deshabilitar el agente FW-LLDP:

l Linux: utilice ethtool para configurar o mostrar el indicador privado disable-fw-lldp.

l FreeBSD: utilice sysctl para configurar o mostrar el indicador fw_lldp.

l ESX: utilice el comando esxcfg-module para configurar u obtener el parámetro del módulo LLDP.

l Microsoft Windows: utilice el atributo de agente LLDP en UEFI HII para cambiar la configuración de FW-LLDP.

Nota: Debe activar el atributo "LLDP AGENT" de UEFI HII para aplicar la configuración de FW-LLDP. Si la

opción "LLDP AGENT" se ha deshabilitado en UEFI HII, no podrá habilitar FW-LLDP desde el sistema

operativo.

l Debe habilitar el agente LLDP en UEFI HII para utilizar DCB.

Particiones NIC

Particiones de tarjeta de interfaz de red (NIC) (NPar) permite a los administradores de red crear varias particiones

para cada puerto físico en una tarjeta de adaptador de red y establecer diferentes asignaciones de ancho de banda

en cada partición. Para la red y el sistema operativo, cada partición aparece como un puerto físico independiente en el

adaptador. Esto facilita la reducción del número de puertos de conmutación y la complejidad de cableado mientras se

mantiene la segmentación de red y el aislamiento. Además, la asignación de ancho de banda flexible por partición

permite el uso eficiente del enlace.

NPar está disponible en Linux y ESXi, así como en las versiones de Windows Server y Windows Server Core a partir

de 2012 R2.

Los siguientes adaptadores admiten NPar. Tenga en cuenta que NPar admite un máximo de 8 particiones por

controlador.

l Adaptador Intel® Ethernet 25G 2P XXV710

NOTA: los adaptadores 25GbE no son compatibles con NPAR y NPAR-EP en sistemas operativos

VMWare.

l Intel® Ethernet 10G 4P X710/I350 rNDC

l Intel® Ethernet 10G 4P X710-k bNDC

l Intel® Ethernet 10G 4P X710 rNDC

l Intel® Ethernet 10G 2P X710-k bNDC

l Intel® Ethernet 10G X710-k bNDC

l Adaptador de Ethernet de red convergente Intel® X710

l Adaptador de red convergente Intel® X710-T

l Intel® Ethernet Server Adapter X710-DA2 para OCP para servidores

NOTAS:

l Los adaptadores solo admiten NPar en modo NIC (LAN).

l Los siguientes elementos son compatibles únicamente en la primera partición de cada puerto:

l PXE Boot

l iSCSI Boot

l Configuraciones de velocidad y dúplex

l Control de flujo

l Opciones de administración de energía

l SR-IOV

l Procesamiento de NVGRE

l Algunos adaptadores solo admiten Wake on LAN en la primera partición del primer puerto.

l Los límites de recursos de Microsoft Windows pueden afectar al número de puertos que se muestran. Si

tiene varios adaptadores instalados en un sistema y habilita NPar o NParEP en los adaptadores, el

Administrador de dispositivos de Windows podría no mostrar todos los puertos.

l Es posible que el ancho de banda mínimo no esté distribuido equitativamente entre las particiones NIC

al cambiar el modo NPAR/NPAR EP. Los valores de ancho de banda mínimo se pueden ajustar

después de cambiar el modo NPAR/NPAR EP.

l La descarga de iSCSI no admite particiones NIC de dispositivos basados en Intel X710. Los

adaptadores X710 muestran incorrectamente un valor "True" para "Compatibilidad con descarga de

iSCSI". Mediante la activación del "modo descarga de iSCSI" de la página [NIC Partitioning

Configuration] se activa la partición del tráfico de almacenamiento de iSCSI.

l La prueba de diagnóstico de bucle de retorno no se admite cuando el dispositivo está en modo NPAR.

l Cuando configure el sistema para un sistema operativo basado en Microsoft Windows, no active el

modo descarga de iSCSI en la configuración de partición para dispositivos Intel® X710, ya sea

directamente en la BIOS a través de HII o mediante una configuración remota como racadm o WSMAN.

l Si tiene NPAR activado, asegúrese de que la configuración avanzada "Perfil de equilibrio de cargas

RSS" está establecida en NUMAScalingStatic.

l NVGRE no se admite cuando el dispositivo está en modo NPAR. Si el dispositivo tiene NPAR activado,

NVGRE (el ajuste de descarga de tareas encapsuladas de la ficha Avanzado del administrador de

dispositivos de Windows) no se admite.

l Con NPAR activado en dispositivos de la serie X700 de controladores Intel® Ethernet, todas las

particiones perderán la conexión de red durante 2-3 segundos mientras se inicializa la partición raíz (la

primera partición del puerto físico).

Modo NParEP

El modo NParEP es una combinación de NPar y PCIe ARI, y aumenta el número máximo de particiones en un

adaptador a 16 por controlador.

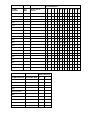

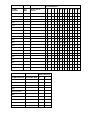

Compatibilidad con la plataforma NParEP

Ranura PCI Express

Dell EMC

Plataforma

OCP

Mezz

Ranura NDC de

bastidor

1 2 3 4 5 6 7 8 9 10 11 12 13

C4130 sí sí

C4140 no sí no sí

C6420 sí sí

R230 no no

R240 no no

R330 no no

R340 no no

R430 sí sí

R440 sí sí sí

R530 sí sí sí no no

Ranura PCI Express

Dell EMC

Plataforma

OCP

Mezz

Ranura NDC de

bastidor

1 2 3 4 5 6 7 8 9 10 11 12 13

R530XD sí sí no

R540 sí sí sí sí sí no

R630 sí sí sí sí

R640 sí sí sí sí

R730 sí sí sí sí sí sí sí sí

R730XD sí sí sí sí sí sí sí

R740 sí sí sí sí sí sí sí sí sí

R740XD2 no sí sí sí sí sí no

R830 sí sí sí sí sí sí sí

R840 sí sí sí sí sí sí sí sí sí sí sí

R930 sí sí sí sí sí sí sí sí sí sí sí

R940 sí sí sí sí sí sí sí sí sí sí sí sí sí sí

T130 no no no no

T140 no no no no

T330 no no no sí

T340 no no no no

T430 no no sí sí sí sí

T440 no sí sí sí sí

T630 sí no sí sí sí sí sí

T640 sí sí sí sí sí sí sí sí sí

Ranura Mezzanine

Dell EMC Plataforma Ranura NDC Blade B C

FC430

FC630 sí

FC830 sí

M630 sí

M630 para VRTX sí

M640 sí

M640 para VRTX sí

M830 sí

M830 para VRTX sí

MX740c sí sí

Ranura Mezzanine

Dell EMC Plataforma Ranura NDC Blade B C

MX840c sí sí

Las plataformas o ranuras compatibles se indican con "sí". Las plataformas no compatibles se indican con un "no".

Cuando no es aplicable, se indica con celdas en blanco.

Configuración del modo NPar

Configuración de NPar desde el Administrador de inicio

Al iniciar el sistema, pulse la tecla F2 para acceder al menú System Setup (Configuración del sistema). Seleccione

Device Settings (Configuración de dispositivo) de la lista que aparece en System Setup Main Menu (Menú principal

de configuración del sistema) y, a continuación, seleccione su adaptador de la lista para acceder al menú de

Configuración de dispositivo. Seleccione Device Level Configuration (Configuración de nivel de dispositivo) en la

lista que aparece en Main Configuration Page (Página principal de configuración). Aparecerá la configuración de

virtualización en Device Level Configuration (Configuración de nivel de dispositivo).

En la lista desplegable Virtualization Mode (Modo de virtualización) hay cuatro opciones.

l None (Ninguno): el adaptador funciona con normalidad.

l NPar: permite un máximo de 8 particiones en el adaptador. Si selecciona el modo de virtualización NPar, se le

presentará la opción de habilitar el modo NParEP, que ampliará el número de particiones por adaptador a un

total de 16, emparejando NPar con PCIe ARI.

NOTAS:

l Cuando un adaptador está funcionando en el modo NPar, se limita a 8 particiones en total. Un

adaptador de dos puertos tendrá cuatro particiones por puerto. Un adaptador de cuatro puertos

tendrá dos particiones por puerto.

l El modo NParEP solo se puede activar cuando el modo NPar está habilitado.

l Cuando un adaptador está funcionando en el modo NParEP, se limita a 16 particiones en total.

Un adaptador de dos puertos tendrá ocho particiones por puerto. Un adaptador de cuatro

puertos tendrá cuatro particiones por puerto.

l SR-IOV: activa SR-IOV en el puerto.

l NPar+SR-IOV: permite hasta 8 particiones (funciones físicas) para el adaptador y activa SR-IOV.

NOTAS:

l SR-IOV está limitado a la partición raíz de cada puerto.

l Cuando un adaptador se ejecuta en modo NPar, la configuración de virtualización (SR-IOV) se

aplica a todos los puertos del adaptador y a todas las particiones de cada puerto. Los cambios

realizados en la configuración de virtualización en un puerto se aplican a todos los puertos del

adaptador.

Cuando haya terminado la selección, haga clic en el botón Back (Regresar) y regresará a la Main Configuration

Page (Configuración de la página principal). Haga clic en el nuevo elemento, titulado NIC Partitioning Configuration

(Configuración de particiones NIC) en la lista de configuraciones para ir a la página NIC Partitioning Configuration,

donde verá una lista con las particiones NPar (o NParEP) que hay en el adaptador.

La página Global Bandwith Allocation (Asignación de ancho de banda global) le permite especificar el mínimo y el

máximo de asignación de ancho de banda garantizado para cada partición en un puerto. El ancho de banda TX

mínimo es el ancho de banda de transmisión de datos mínimo garantizado, como porcentaje de la velocidad completa

de enlace de puerto físico, que recibirá la partición. El ancho de banda que se concede a la partición no caerá nunca

por debajo del nivel que se especifica aquí. El rango de valores válido es:

De 1 a (100 menos (número de particiones en el puerto físico) más 1).

Por ejemplo, si un puerto físico tiene 4 particiones, el rango sería:

De 1 a ((100 - 4) + 1 = 97)

El porcentaje de ancho de banda máximo representa el ancho de banda de transmisión máximo asignado a la

partición como porcentaje de la velocidad máxima de enlace del puerto físico. El rango de valores aceptado es de 0-

100. El valor puede utilizarse como limitador, en caso de que elija que una función determinada no pueda consumir el

100 % del ancho de banda de un puerto (si estuviera disponible). La suma de todos los valores de ancho de banda

máximo no está limitada, pues no se puede utilizar nunca más del 100 % del ancho de banda de un puerto.

NOTA:

l Si la suma de los porcentajes de ancho de banda mínimo no es igual a 100, la configuración se ajusta

automáticamente para que la suma sea igual a 100.

l Si el porcentaje de ancho de banda máximo de una partición se establece en un valor menor que el

porcentaje de ancho de banda mínimo de la partición, entonces el porcentaje de ancho de banda

máximo se establecerá automáticamente en el valor del porcentaje de ancho de banda mínimo.

l Cuando intenta establecer los valores para el porcentaje de ancho de banda mínimo a través del

iDRAC con el controlador de ciclo de vida mediante el uso de trabajos que no incluyen los valores para

todas las particiones habilitadas, entonces los valores que se obtienen una vez finalizados los trabajos

pueden ser diferentes de los valores que supuestamente se habían establecido. Para evitar este

problema, establezca los valores de porcentaje de ancho de banda mínimo en todas las particiones

mediante el uso de un único trabajo, y asegúrese de que la suma de los valores es 100.

Haga clic en el botón Back (Regresar) cuando haya terminado de realizar la configuración de la asignación de ancho

de banda para volver a la página NIC Partitioning Configuration. Desde allí puede hacer clic en uno de los elementos

de la lista PartitionnConfiguration (Configuración de la partición n) en Global Bandwidth Allocation (Asignación de

ancho de banda global). Aparecerá una página de información de configuración de particiones en un puerto en

particular. Puede ver el modo de NIC, PCI; ID del dispositivo, Dirección PCI, la dirección MAC y la dirección MAC

virtual (si procede) para todas las particiones de cualquier puerto al hacer clic en los elementos de la lista de

configuración de la partición.

Cuando haya finalizado la configuración de todas las particiones de un puerto, vuelva a la página de configuración

principal, haga clic en el botón Finish (Finalizar) y luego haga clic en el botón OK (Aceptar) del cuadro de diálogo

Success (Saving Changes) (Correcto (Guardando los cambios)).

Repita el proceso de configuración de partición de todos los puertos de su adaptador.

NOTA: una vez que NPar se ha habilitado en una partición de un puerto, aparecerá habilitado para todas las

particiones posteriores en ese puerto. Si esa primera configuración de NPar incluía habilitar el modo NParEP,

el modo NParEP también aparecerá habilitado en todas las particiones posteriores en ese puerto.

Cuando haya configurado todas las particiones de todos los puertos en todos los adaptadores del servidor, vuelva al

menú principal de configuración del sistema y haga clic en el botón Finish (Finalizar). Luego, haga clic en Yes (Sí)

para salir del menú de configuración del sistema y reinicie el sistema con el fin de aplicar los cambios.

Una vez que el sistema haya completado el proceso de arranque, NPar permanecerá habilitado hasta que lo

deshabilite explícitamente desactivando la opción durante una secuencia de arranque posterior.

Configuración de NPar en Microsoft Windows

Es posible configurar una partición de puerto de adaptador en Windows como cualquier puerto de adaptador. Ejecute

el Administrador de dispositivos, seleccione el dispositivo y abra las hojas de propiedades de la partición para

configurar las opciones.

NOTA: En Microsoft* Windows Server* 2019 (y versiones posteriores), debe utilizar Intel® PROSet para

Windows PowerShell para configurar NPar.

Activación de NPar

NPar se activa y desactiva desde la ficha Advanced (Avanzado) en la hoja de propiedades del Administrador de

dispositivos.

Para cambiar esta configuración en Windows PowerShell, utilice el cmdlet Set-IntelNetAdapterSetting. Por ejemplo:

Set-IntelNetAdapterSetting -Name "<nombre_adaptador>" -DisplayName "NIC Partitioning" –DisplayValue "NPAR"

Opciones de arranque

En la ficha Boot Options (Opciones de arranque), se le informará de que el dispositivo está en modo NPar y que los

ajustes antiguos de protocolo de prearranque solo se pueden configurar en la partición raíz. Al hacer clic en el botón

Properties (Propiedades) se iniciará la hoja de propiedades de la partición raíz en el adaptador.

Para establecer esta opción mediante Windows PowerShell, busque la primera partición mediante el cmdlet Get-

IntelNetAdapter. Una vez que conozca el puerto con el número de partición 0, utilice ese nombre de puerto en la

utilidad Bootutil para la configuración de opciones de arranque.

Opciones de administración de energía

La configuración de administración de energía solo se permite en la primera partición de cada puerto físico. Si

selecciona la ficha Power Management (Administración de energía) en las hojas de propiedades del Administrador

de dispositivos mientras se selecciona cualquier partición que no sea la primera, se le presentará texto en el diálogo

de administración de energía que indicará que no se pueden configurar los ajustes de administración de energía en la

conexión actual. Al hacer clic en el botón Properties (Propiedades) se iniciará la hoja de propiedades de la partición

raíz en el adaptador.

NOTA: las opciones de arranque y la configuración de administración de energía solo están disponibles en la

partición raíz de cada puerto físico.

Para establecer esta opción mediante Windows PowerShell, busque la primera partición mediante el cmdlet Get-

IntelNetAdapter. Una vez que conozca el puerto con el número de partición 0, utilice ese nombre de puerto con los

cmdlets Get-IntelNetAdapterSetting y Set-IntelNetAdapterSetting.

Control de flujo

Puede cambiar la configuración del control de flujo para cualquier partición en un puerto determinado. No obstante,

cuando se realiza un cambio en la configuración de control de flujo de una partición asociada a un puerto en un

adaptador que funciona en modo NPar, el nuevo valor se aplicará a todas las particiones de ese puerto concreto.

El control de flujo se alcanza al seleccionar la ficha Advanced (Avanzado) de Intel PROset y, a continuación,

seleccionar el botón Properties (Propiedades) y Flow Control (Control de flujo) de la lista de opciones de la lista

Settings (Ajustes) del diálogo que se muestra.

Para cambiar esta configuración en Windows PowerShell, utilice el cmdlet Set-IntelNetAdapterSetting. Por ejemplo,

Set-IntelNetAdapterSetting -Name "<nombre del adaptador>" -DisplayName "Control de flujo" -DisplayValue

“Negociación automática”.

Identificación de las asociaciones de puerto

El diálogo Hardware Information (Información del hardware) en las hojas de propiedades de Intel PROSet facilita la

identificación del puerto físico asociado a una partición concreta. Hay un botón Identify Adapter (Identificar

adaptador) en la ficha Link Speed (Velocidad de enlace) y al hacer clic en ese botón parpadeará el indicador

luminoso ACK/Link en el puerto asociado a la partición activa.

Para cambiar esta configuración en Windows PowerShell, utilice el cmdlet Test-IntelNetAdapterSetting. Por ejemplo,

Test-IntelNetIdentifyAdapter -Name "<nombre del adaptador>" -Seconds 100.

Configuración de ancho de banda de partición

El diálogo Bandwidth Configuration (Configuración de ancho de banda) proporciona una indicación del puerto para el

que se están realizando ajustes en la actualidad, sobre una lista de las particiones de ese puerto y sus asignaciones

de ancho de banda actuales (Min%, Max%). La configuración del ancho de banda de la partición se alcanza al hacer

clic en el botón Bandwidth Configuration (Configuración del Ancho de Banda) en la ficha Link Speed (Velocidad de

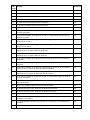

enlace) de las hojas de propiedades de Intel PROSet.

El ancho de banda asignado a cada partición en el puerto nunca caerá por debajo del valor definido en Min%. Para

todas las particiones en el mismo puerto físico, el porcentaje de ancho de banda mínimo para todas las particiones

debe establecerse en cero, o la suma de todos los porcentajes mínimos de ancho de banda en cada partición debe

ser igual a 100, donde el rango de porcentajes de ancho de banda mínimos está entre 1 y (100-n)%, siendo n el

número de particiones de un puerto en particular. Por ejemplo, en un puerto con cuatro particiones definidas:

P1=0

P2=0

P3=0

P4=0

Válida

P1=10

P2=20

P3=30

P4=40

Válida

P1=20

P2=80

P3=0

P4=0

NO válida

Los valores válidos para Max% son el valor de "Min%" de esa partición hasta "100". Por ejemplo, si el valor de Min%

para la Partición 1 es 50%, el rango de Max% de esa partición es "50"-"100". Si hace que el valor Max% de una

partición supere el 100% incrementando el valor con el control de número, se muestra un error y se reduce Max%

hasta 100 %. La suma de los valores Max% de todas las particiones de un puerto concreto no tiene límites.

Para cambiar el valor de Min% o Max%, seleccione una partición en la lista que se muestra y utilice las flechas hacia

arriba o hacia abajo en “Selected Partition Bandwidth Percentages” (Porcentajes de ancho de banda de la partición

seleccionada).

NOTA:

l Si la suma de los porcentajes de ancho de banda mínimo no es igual a 100, la configuración se ajusta

automáticamente para que la suma sea igual a 100.

l Si el porcentaje de ancho de banda máximo de una partición se establece en un valor menor que el

porcentaje de ancho de banda mínimo de la partición, entonces el porcentaje de ancho de banda

máximo se establecerá automáticamente en el valor del porcentaje de ancho de banda mínimo.

l Cuando intenta establecer los valores para el porcentaje de ancho de banda mínimo a través del

iDRAC con el controlador de ciclo de vida mediante el uso de trabajos que no incluyen los valores para

todas las particiones habilitadas, entonces los valores que se obtienen una vez finalizados los trabajos

pueden ser diferentes de los valores que supuestamente se habían establecido. Para evitar este

problema, establezca los valores de porcentaje de ancho de banda mínimo en todas las particiones

mediante el uso de un único trabajo, y asegúrese de que la suma de los valores es 100.

Para cambiar esta configuración en Windows PowerShell, utilice el cmdlet Set-IntelNetAdapterSetting. Por ejemplo:

Set-IntelNetAdapterMaximumBandwidthPercentage -Name "Adaptador de red convergente Intel® Ethernet X710" -

MaxBwPercent 100

Set-IntelNetAdapterMinimumBandwidthPercentage -Name "Adaptador de red convergente Intel® Ethernet X710" -

Partition1 25 -Partition2 25 -Partition3 25 -Partition4 25

Configuraciones de velocidad y dúplex

La configuración de velocidad y dúplex para un puerto en particular puede cambiarse desde cualquier partición

asociada a ese puerto. Sin embargo, como todas las particiones de un puerto concreto en un adaptador que funciona

en modo NPar comparten el mismo módulo que se conecta al puerto, el cambio de la configuración de velocidad y

dúplex se traducirá en que el nuevo valor se establezca en todas las particiones en el mismo puerto físico.

Cambiar la configuración de velocidad y dúplex de un puerto en un adaptador que funciona en modo NPar hará que

se vuelva a cargar el controlador de cada partición asociada a ese puerto. Esto puede producir una pérdida

momentánea de enlace.

Diagnósticos en línea

Se pueden realizar pruebas en línea en el modo NPar sin perder el enlace del adaptador. Las siguientes pruebas de

diagnóstico están disponibles para todas las particiones de un puerto determinado, mientras un adaptador funcione

en modo NPar:

l EEPROM

l Registro

l Integridad de NVM

l Conexión

Para cambiar esta configuración en Windows PowerShell, utilice el cmdlet Test-IntelNetAdapterSetting. Por ejemplo,

Test-IntelNetDiagnostics -Name "<nombre del adaptador>" -Test Hardware.

Diagnósticos sin conexión

No se admiten diagnósticos sin conexión mientras el adaptador funcione en modo NPar. Las pruebas de bucle de

retorno y cable sin conexión no están permitidas en modo NPar.

Para cambiar esta configuración en Windows PowerShell, utilice el cmdlet Test-IntelNetAdapterSetting. Por ejemplo,

Test-IntelNetDiagnostics -Name "<nombre del adaptador>" -Test Hardware.

Virtualización

La configuración de la virtualización (colas de máquina virtual y SR-IOV) se alcanza a través de las hojas de

propiedades de Intel PROSet, al seleccionar la ficha Avanzado y seleccionar "Virtualización" de la lista Ajustes.

Cuando un adaptador está funcionando en modo NPar, solo la primera partición de cada puerto físico puede estar

configurada con la configuración de virtualización.

NOTA: Microsoft* Hyper-V* debe estar instalado en el sistema a fin de que la configuración de virtualización

esté disponible. Si Hyper-V* no está instalado, la ficha Virtualización de PROSet no aparecerá.

Para establecer esta opción mediante Windows PowerShell, busque la primera partición mediante el cmdlet Get-

IntelNetAdapter. Una vez que conozca el puerto con el número de partición 0, utilice ese nombre de puerto con los

cmdlets Get-IntelNetAdapterSetting y Set-IntelNetAdapterSetting.

Configuración de NPAR en Linux

En los adaptadores Intel® basados en la serie 710 que lo admiten, puede configurar varias funciones en cada puerto

físico. Configure estas funciones mediante la Configuración del sistema/BIOS.

El ancho de banda TX mínimo es el ancho de banda de transmisión de datos mínimo garantizado, como porcentaje de

la velocidad completa de enlace de puerto físico, que recibirá la partición. El ancho de banda que se concede a la

partición no caerá nunca por debajo del nivel que se especifica aquí.

El rango de los valores mínimos de ancho de banda es:

De 1 a (100 menos (número de particiones en el puerto físico) más 1).

Por ejemplo, si un puerto físico tiene 4 particiones, el rango sería:

De 1 a ((100 - 4) + 1 = 97)

El porcentaje de ancho de banda máximo representa el ancho de banda de transmisión máximo asignado a la

partición como porcentaje de la velocidad máxima de enlace del puerto físico. El rango de valores válido es 1-100. El

valor puede utilizarse como limitador, en caso de que elija que una función determinada no pueda consumir el 100 %

del ancho de banda de un puerto (si estuviera disponible). La suma de todos los valores de ancho de banda máximo

no está limitada, pues no se puede utilizar nunca más del 100 % del ancho de banda de un puerto.

NOTA:

l Si la suma de los porcentajes de ancho de banda mínimo no es igual a 100, la configuración se ajusta

automáticamente para que la suma sea igual a 100.

l Si el porcentaje de ancho de banda máximo de una partición se establece en un valor menor que el

porcentaje de ancho de banda mínimo de la partición, entonces el porcentaje de ancho de banda

máximo se establecerá automáticamente en el valor del porcentaje de ancho de banda mínimo.

l Cuando intenta establecer los valores para el porcentaje de ancho de banda mínimo a través del

iDRAC con el controlador de ciclo de vida mediante el uso de trabajos que no incluyen los valores para

todas las particiones habilitadas, entonces los valores que se obtienen una vez finalizados los trabajos

pueden ser diferentes de los valores que supuestamente se habían establecido. Para evitar este

problema, establezca los valores de porcentaje de ancho de banda mínimo en todas las particiones

mediante el uso de un único trabajo, y asegúrese de que la suma de los valores es 100.

Una vez finalizada la configuración inicial, puede establecer asignaciones de ancho de banda diferentes en cada

función de la manera siguiente:

1. Cree un directorio nuevo denominado /config

2. Edite etc/fstab para que incluya:

configfs /config configfs defaults

3. Cargue (o recargue) el controlador i40e

4. Monte /config

5. Cree un directorio nuevo bajo config para cada partición en la que desee configurar el ancho de banda.

Aparecerán tres archivos en el directorio config/partition:

- max_bw

- min_bw

- commit

Lea en max_bw para visualizar el ajuste máximo actual de ancho de banda.

Escriba en max_bw para establecer el ancho de banda máximo de esta función.

Lea en min_bw para visualizar el ajuste mínimo actual de ancho de banda.

Escriba en min_bw para establecer el ancho de banda mínimo de esta función.

Escriba '1' en commit para guardar los cambios.

NOTAS:

l commit es de solo escritura. Si intenta leerlo, recibirá un error.

l La escritura en commit solo se admite en la primera función de un puerto determinado. Si escribe en

una función posterior, recibirá un error.

l No se admite superar el ancho de banda mínimo. El NVM del dispositivo subyacente establecerá el

ancho de banda mínimo en los valores admitidos de una manera indeterminada. Elimine todos los

directorios que estén bajo config y vuelva a cargarlos para ver cuáles son los valores reales.

l Para descargar el controlador, primero debe eliminar los directorios creados anteriormente en el paso 5.

Ejemplo de establecer el ancho de banda mínimo y máximo (suponiendo que haya cuatro funciones en el puerto eth6-

eth9 y que eth6 es la primera función del puerto):

# mkdir /config/eth6

# mkdir /config/eth7

# mkdir /config/eth8

# mkdir /config/eth9

# echo 50 > /config/eth6/min_bw

# echo 100 > /config/eth6/max_bw

# echo 20 > /config/eth7/min_bw

# echo 100 > /config/eth7/max_bw

# echo 20 > /config/eth8/min_bw

# echo 100 > /config/eth8/max_bw

# echo 10 > /config/eth9/min_bw

# echo 25 > /config/eth9/max_bw

# echo 1 > /config/eth6/commit

Salir del modo NPar

El modo NPar se desactiva en el menú de configuración del sistema durante el reinicio.

Reinicie el sistema y pulse la tecla F2 para acceder al menú System Setup (Configuración del sistema). Seleccione

Device Settings (Configuración de dispositivo) de la lista que aparece en System Setup Main Menu (Menú principal

de configuración del sistema) y, a continuación, seleccione su adaptador de la lista para acceder al menú de

Configuración de dispositivo. Seleccione Device Level Configuration (Configuración de nivel de dispositivo) en la

lista que aparece en Main Configuration Page (Página principal de configuración). Aparecerá la configuración de

virtualización en Device Level Configuration (Configuración de nivel de dispositivo).

En la lista Virtualization Mode (Modo de virtualización), seleccione "None" (Ninguno). A continuación, haga clic en el

botón Back (Regresar), que le devolverá a la página de configuración principal. En ella, haga clic en el botón Finish

(Finalizar) para guardar el cambio y reiniciar el sistema. Cuando el sistema acabe de reiniciarse, NPar ya no estará

activo.

NOTA: cuando NPar ha sido deshabilitado y el sistema completa el reinicio, también se deshabilitan otros

ajustes relacionados con la virtualización, como NParEP o SR-IOV.

Instalación del adaptador

Seleccionar la ranura correcta

Una ranura PCI-Express x4, x8 o x16 abierta; en función de su adaptador.

NOTA: algunos sistemas cuentan con ranuras físicas PCI Express x8 que admiten velocidades menores.

Consulte el manual del sistema para identificar la ranura.

Insertar el adaptador en el equipo

1. Si su equipo admite conexión en funcionamiento PCI, consulte la documentación del equipo para obtener

instrucciones de instalación específicas.

2. Apague y desconecte el equipo. A continuación, retire la cubierta.

PRECAUCIÓN: apague y desconecte la fuente de alimentación antes de retirar la cubierta del equipo.

Si no lo hace, puede ser peligroso y además puede dañar el adaptador o el equipo.

3. Retire el soporte de cubierta de una ranura disponible.

4. Introduzca el adaptador en la ranura hasta que encaje correctamente. Puede instalar un adaptador PCI

Express más pequeño en una ranura PCI Express más grande.

PRECAUCIÓN: algunos adaptadores PCI Express pueden tener un conector corto, lo que los

hace más frágiles que los adaptadores PCI. Una fuerza excesiva podría romper el conector.

Tenga cuidado al presionar la placa para introducirla en la ranura.

5. Asegure la abrazadera del adaptador con un tornillo si es necesario.

6. Vuelva a colocar la cubierta y conecte el cable de alimentación.

7. Encienda el equipo.

Conexión de los cables de red

Conecte el cable de red adecuado tal como se describe en las secciones siguientes.

Conexión del cable de red RJ-45

Conecte el cable de red RJ-45 tal y como se muestra en la ilustración:

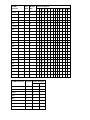

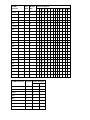

La siguiente tabla muestra las longitudes máximas para cada tipo de cable a una velocidad de transmisión

determinada.

Categoría 5 Categoría 6 Categoría 6a Categoría 7

1 Gbps 100 m 100 m 100 m 100 m

10 Gbps (no disponible) 55 m 100 m 100 m

25 Gbps (no disponible) (no disponible) (no disponible) 50 m

40 Gbps (no disponible) (no disponible) (no disponible) 50 m

ADVERTENCIA: si utiliza cables con menos de 4 pares, deberá configurar manualmente la velocidad y el

dúplex del adaptador y del interlocutor de enlace. Además, con cables de 2 y 3 pares, el adaptador

solamente podrá alcanzar velocidades de hasta 100 Mbps.

En todos los casos:

l El adaptador debe estar conectado a un interlocutor de enlace compatible, de preferencia que se haya

establecido para negociar automáticamente la velocidad y el dúplex de los adaptadores Intel Gigabit.

l Los adaptadores Intel Gigabit y 10 Gigabit para servidor que utilizan conexiones de cobre se adaptan

automáticamente a las conexiones MDI o MDI-X. La función de adaptación automática a MDI-X de los

adaptadores Intel Gigabit de cable de cobre permite conectar directamente dos adaptadores sin necesidad de

utilizar un cable de cruzamiento.

Módulos SFP+ y QSFP+ admitidos

Los adaptadores Intel® Ethernet para servidores solo admiten la óptica de Intel y/o todos los cables de conexión

directa de limitación activa y pasiva que cumplen las especificaciones SFF-8431 v4.1 y SFF-8472 v10.4.

Especificaciones de cableado del transceptor SR

Longitud de onda láser: 850 nanómetros (no visible).

Tipo de conector: LC o SC.

Tipo de cable: fibra multimodo con un diámetro de núcleo de 62,5 µm.

l Longitud máxima de cable a 1 Gbps: 275 metros.

l Longitud máxima de cable a 10 Gbps (o superior): 33 metros.

Tipo de cable: fibra multimodo con un diámetro de núcleo de 50 µm.

l Longitud máxima de cable a 1 Gbps: 550 metros.

l Longitud máxima de cable a 10 Gbps (o superior): 300 metros.

Especificaciones de cableado del transceptor LR

Longitud de onda láser: 1310 nanómetros (no visible).

Tipo de conector: LC.

Tipo de cable: fibra monomodo con un diámetro de núcleo de 9,0 µm.

l Longitud máxima del cable: 10 kilómetros.

La mayoría de los adaptadores Intel® Ethernet para servidores son compatibles con los siguientes módulos:

NOTA: los dispositivos Intel® basados en la serie 710 no admiten módulos de terceros.

Proveedor Tipo Números de pieza Adaptadores

compatibles

Dell EMC 1G/10G SFP+ SR de doble velocidad (con

palanca de bloqueo)

Y3KJN, XYD50,

C5RNH

1

, WTRD1

1

X520, X710

2

,

XXV710

Dell EMC 10G/25G SFP28 de doble velocidad M14MK XXV710

Dell EMC QSFP+ F10 pasivo tipo pulpo (QSFP+ a 4xSFP+) P4YPY, TCPM2, JNPF8,

27GG5, P8T4W

X520, X710

2

Dell EMC Transceptor de SFP+ a 1000BASET 8T47V, XTY28 X710

2

Dell EMC SFP+ LR Optic 60F4J, RN84N

X710

2

Dell EMC Cable óptico activo (AOC) YJF03, P9GND, T1KCN,

1DXKP, MT7R2, K0T7R,

W5G04

X710

2

, XXV710

Dell EMC SFP28 óptico P7D7R, HHHHC,

68X15, OYR96, W4GPP

XXV710

Dell EMC SFP+ F10 pasivo C6Y7M, V250M,

5CWK6, 53HVN, 358VV,

MV799

XXV710

Dell EMC SFP28 pasivo 2JVDD, D0R73, VXFJY,

9X8JP

XXV710

Dell EMC SFP28 activo 3YWG7, 5CMT2,

RCVP5, X5DH4

XXV710

Dell EMC QSFP28 F10 pasivo tipo pulpo (QSFP+ a

4xSFP28)

26FN3, YFNDD, 7R9N9 XXV710

Dell EMC Cables multiconector pasivos QSFP28 8R4VM, 7VN5T, D9YM8 XXV710

Dell EMC 1G/10G/40G QSFP+ SR DE TRIPLE VELOCIDAD

(con palanca de bloqueo) (1G y 10G no se

admiten en XL710)

9GCCD, 7TCDN,

5NP8R, FC6KV, J90VN

XL710

1

No se admite en los adaptadores basados en el controlador X520 de Intel®.

2

El Intel® Ethernet Server Adapter X710-DA2 para servidores para OCP solo es compatible con los módulos incluidos

en la tabla siguiente:

El Intel® Ethernet Server Adapter X710-DA2 para servidores para OCP solo es compatible con los módulos

siguientes:

Proveedor Tipo Números de pieza

Dell EMC SFP+ SR High Temp Optics N8TDR

Dell EMC QSFP+ F10 pasivo tipo pulpo TCPM2, 27GG5, P8T4W

LOS MÓDULOS Y CABLES ÓPTICOS DE OTRAS EMPRESAS A LOS QUE SE HA HECHO REFERENCIA

ANTERIORMENTE SE HAN INCLUIDO SOLO CON EL FIN DE RESALTAR LAS ESPECIFICACIONES Y

COMPATIBILIDAD POTENCIAL DE PRODUCTOS DE OTRAS EMPRESAS Y NO SON RECOMENDACIONES, APOYO

NI PATROCINIO POR PARTE DE INTEL DE NINGÚN PRODUCTO DE OTRAS EMPRESAS. INTEL NO RESPALDA NI

PROMOCIONA PRODUCTOS FABRICADOS POR OTRAS EMPRESAS, Y LA REFERENCIA A LOS MISMOS SE

PROPORCIONA ÚNICAMENTE PARA COMPARTIR INFORMACIÓN RELATIVA A DETERMINADOS MÓDULOS Y

CABLES ÓPTICOS CON LAS ESPECIFICACIONES ANTEDICHAS. PUEDE QUE HAYA OTROS FABRICANTES O

PROVEEDORES QUE PRODUZCAN O SUMINISTREN MÓDULOS Y CABLES ÓPTICOS CON DESCRIPCIONES

SIMILARES O COINCIDENTES. LOS CLIENTES DEBEN UTILIZAR SU PROPIO CRITERIO Y DILIGENCIA PARA

COMPRAR MÓDULOS Y CABLES ÓPTICOS DE LA EMPRESA QUE ELIJAN. LOS CLIENTES SON LOS ÚNICOS

RESPONSABLES DE VALORAR LA ADECUACIÓN DEL PRODUCTO Y/O DE LOS DISPOSITIVOS, ASÍ COMO DE LA

SELECCIÓN DEL PROVEEDOR PARA COMPRAR CUALQUIER PRODUCTO. LOS MÓDULOS Y CABLES ÓPTICOS

A LOS QUE SE HA HECHO REFERENCIA ANTERIORMENTE NO TIENEN GARANTÍA NI SOPORTE DE INTEL. INTEL

NO ASUME NINGUNA RESPONSABILIDAD Y ESTÁ EXENTO DE CUALQUIER GARANTÍA EXPRESA O IMPLÍCITA

RELATIVA A LA VENTA Y/O USO DE ESTOS PRODUCTOS DE OTRAS EMPRESAS O LA SELECCIÓN DEL

PROVEEDOR REALIZADA POR LOS CLIENTES.

Conexión del cable de conexión directa

Introduzca el cable de red de conexión directa según se ilustra a continuación.

Tipo de cables:

l 40 Gigabit Ethernet por cable SFP+ de conexión directa (Biaxial)

l La longitud máxima es de 7 metros.

l 25 Gigabit Ethernet por cable SFP28 de conexión directa (Biaxial)

l La longitud máxima es de 5 metros.

l Para un rendimiento óptimo, debe utilizar CA-25G-L con RS-FEC y 25GBASE-CR

l 10 Gigabit Ethernet por cable SFP+ de conexión directa (Biaxial)

l La longitud máxima es de 10 metros.

Instalación de una tarjeta Mezzanine en el servidor de hoja

Consulte la documentación del servidor para obtener instrucciones detalladas sobre cómo instalar una tarjeta

Mezzanine.

1. Apague el servidor de hoja, extráigalo del chasis y quítele la cubierta.

ADVERTENCIA: si no apaga el servidor de hoja, usted podría correr peligro y la tarjeta o el

servidor podrían resultar dañados.

2. Levante la palanca de bloqueo e inserte la tarjeta en un zócalo de tarjeta Mezzanine compatible disponible.

Empuje la tarjeta en el zócalo hasta que quede bien asentada.

NOTA: debe haber presente un conmutador o un módulo de paso en el mismo tejido que la tarjeta del

chasis para proporcionar una conexión física. Por ejemplo, si la tarjeta Mezzanine se inserta en el tejido

B, deberá haber también presente un conmutador en el tejido B del chasis.

3. Repita el paso 2 con cada tarjeta que desee instalar.

4. Baje la palanca de bloqueo hasta que encaje sobre la tarjeta o tarjetas.

5. Vuelva a colocar la cubierta del servidor de hoja y vuelva a insertar éste en el chasis.

6. Encienda el equipo.

Instalación de una tarjeta dependiente de red en un servidor

Consulte la documentación de su servidor para ver instrucciones detalladas sobre cómo instalar un bNDC o rNDC.

1. Desactive el servidor y retire su cubierta.

ADVERTENCIA: si no apaga el servidor, podría correr peligro y la tarjeta o el servidor podrían

resultar dañados.

2. Localice el conector de la tarjeta dependiente de red de su servidor. Consulte la documentación del servidor

para más detalles.

3. Inserte la tarjeta dependiente de red en el conector.

4. Apriete los tornillos de la tarjeta dependiente de red para fijarla en su sitio.

5. Sustituya la cubierta del servidor.

Instalación y configuración del software y los

controladores de Microsoft* Windows*

Instalación de los controladores y el software de Windows

NOTA: para instalar o desinstalar satisfactoriamente los controladores o el software, debe contar con privilegios

administrativos en el equipo en el que se va a llevar a cabo el proceso.

Instalación de los controladores

NOTAS:

l Esta instalación actualizará los controladores de todos los adaptadores de red Intel® compatibles de su

sistema.

l La función Revertir al controlador anterior de Windows Server (disponible en la ficha Controlador del

cuadro de diálogo de propiedades del adaptador) no funcionará correctamente si está presente en el

sistema un equipo de adaptadores o Intel PROSet. Antes de utilizar la función Revertir al controlador

anterior, elimine cualquier equipo. A continuación, elimine Intel PROSet mediante la opción Programas

y características del Panel de control de Windows. Consulte Instalación de Intel PROSet para obtener

más información sobre Intel PROSet.

l No se puede utilizar Microsoft Windows Update para actualizar o cambiar a una versión inferior los

controladores de la red Ethernet. Descargue el paquete de controladores más reciente del sitio web de

asistencia.

Antes de instalar o actualizar los controladores, inserte los adaptadores en el equipo y conecte el cable de red. Si

Windows detecta el adaptador nuevo, intenta encontrar un controlador de Windows aceptable que ya esté instalado

con el sistema operativo.

Si lo encuentra, el controlador se instala sin intervención del usuario. Si Windows no encuentra el controlador,

aparece la ventana del asistente de detección de nuevo hardware.

Independientemente de si Windows encuentra el controlador, se recomienda seguir el procedimiento que se indica a

continuación para instalar el controlador. Los controladores de todos los adaptadores Intel compatibles con esta

versión de software están instalados.

1. Descargue los controladores más recientes desde el sitio web de asistencia y transfiéralos al sistema.

2. Si se muestra la pantalla del asistente de detección de nuevo hardware, haga clic en Cancel (Cancelar).

3. Haga doble clic en el archivo descargado.

4. Seleccione Install (Instalar) en la pantalla del paquete de actualizaciones de Dell.

5. Siga las instrucciones del asistente de instalación. Asegúrese de seleccionar Intel PROSet para la instalación.

NOTA: asegúrese de seleccionar la opción de instalación "iSCSI using Data Center Bridging" (iSCSI con

puentes de centro de datos) para sistemas que tienen un dispositivo preparado para NPAR instalado.

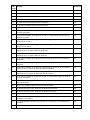

Sintaxis del paquete de actualización de Dell EMC (DUP)

El paquete de actualización de Dell EMC (DUP) es un paquete ejecutable que actualiza los controladores de red en el

sistema.

NOTAS:

l Si está instalando un controlador en un sistema con adaptadores Intel existentes, asegúrese de

actualizar todos los adaptadores y puertos con el mismo controlador y el software Intel® PROSet. Esto

asegurará que todos los adaptadores funcionen correctamente.

Sintaxis

Network_Driver_XXXXX_WN64_XX.X.X_A00.exe [/<option1>[=<value1>]] [/<option2>[=<value2>]]...

Descripciones de las opciones de la línea de comandos

Ninguna Si no se especifican opciones de línea de comandos, el paquete le guiará a través del proceso de

instalación.

/? o /h Muestra la información de uso del paquete de actualización.

/s Suprime todas las interfaces gráficas de usuario del paquete de actualización.

/i Realiza una nueva instalación de los controladores incluidos en el paquete de actualización.

NOTA: se requiere la opción /s

/e=<path> Extrae todo el paquete de actualización en la carpeta definida en <path>.

NOTA: se requiere la opción /s

/drivers=<path> Extrae solo los componentes del controlador del paquete de actualización en la carpeta definida

en <path>.

NOTA: se requiere la opción /s

/driveronly Instala o actualiza solo los componentes del controlador del paquete de actualización.

NOTA: se requiere la opción /s

/passthrough (Avanzado) Envía todo el texto que hay después de la opción /passthrough directamente al

software de instalación del proveedor del paquete de actualización. Este modo suprime cualquier

interfaz gráfica de usuario proporcionada, pero no necesariamente las del software del proveedor.

/capabilities (Avanzado) Devuelve una descripción codificada de las funciones compatibles de este paquete

de actualización.

NOTA: se requiere la opción /s

/l=<path> Define una ruta de acceso específica para el archivo de registro del paquete de actualización.

NOTA: esta opción NO se puede utilizar en combinación con /passthrough ni /capabilities

/f Reemplaza un error de dependencia de software devuelto desde el paquete de actualización.

NOTA: requiere la opción /s y NO se puede utilizar en combinación con /passthrough ni

/capabilities

Ejemplos

Actualizar el sistema en modo silencioso

Network_Driver_XXXXX_WN64_XX.X.X_A00.exe /s

Nueva instalación en modo silencioso

Network_Driver_XXXXX_WN64_XX.X.X_A00.exe /s /i

Extraer el contenido de la actualización en la carpeta C:\mydir

Network_Driver_XXXXX_WN64_XX.X.X_A00.exe /s /e=C:\mydir

Extraer los componentes del controlador en la carpeta C:\mydir

Network_Driver_XXXXX_WN64_XX.X.X_A00.exe /s /drivers=C:\mydir

Instalar solo los componentes del controlador

Network_Driver_XXXXX_WN64_XX.X.X_A00.exe /s /driveronly

Cambiar la ubicación del registro predeterminada a C:\my path with spaces\log.txt

Network_Driver_XXXXX_WN64_XX.X.X_A00.exe /l="C:\my path with spaces\log.txt"

Actualizar de manera forzosa para continuar, incluso con errores de cualificación de software

Network_Driver_XXXXX_WN64_XX.X.X_A00.exe /s /f

Cambiar los controladores a una versión anterior

Puede utilizar las opciones /s y /f para cambiar los controladores a una versión anterior. Por ejemplo, si tiene cargados

los controladores 17.0.0 y desea cambiarlos a la versión 16.5.0, escriba lo siguiente:

Network_Driver_XXXXX_WN64_16.5.0_A00.exe /s /f

Guardar y restaurar la configuración de un adaptador

La herramienta de línea de comandos para guardar y restaurar permite copiar la configuración actual del adaptador

en un archivo independiente (por ejemplo, en una unidad USB) como medida de seguridad. En el caso de que ocurra

un fallo del disco duro, puede recuperar la mayoría de las configuraciones anteriores.

La recuperación de las opciones de configuración de red solo puede realizarse en el mismo sistema (con la misma

configuración) donde se realizó la operación de guardar. Se puede utilizar el archivo donde se haya guardado la

configuración para restaurar la configuración del adaptador después de una actualización del sistema operativo. Sin

embargo, es posible que no se restauren todos los ajustes de configuración del adaptador en función de las funciones

admitidas por el nuevo sistema operativo o software de configuración del adaptador.

NOTAS:

l Solo se guarda la configuración del adaptador. El controlador del adaptador no se guarda.

l Restaure mediante la secuencia de comandos sólo una vez. Si restaura varias veces podría ocasionar

una configuración inestable.

l Intel® PROSet debe estar instalado para que funcione el script SaveRestore.ps1.

l Para los sistemas que funcionan con un sistema operativo de 64 bits, asegúrese de ejecutar la versión

de 64 bits de Windows PowerShell, no la versión de 32 bits (x86), cuando ejecute el script

SaveRestore.ps1.

Sintaxis de la línea de comandos

SaveRestore.ps1 –Action save|restore [-ConfigPath] [-BDF]

SaveRestore.ps1 tiene las siguientes opciones de la línea de comandos:

Opción Descripción

-Action Requerido. Valores válidos: save | restore.

La opción save guarda la configuración del adaptador que ha cambiado respecto a la configuración

predeterminada. Cuando se restaura con el archivo resultante, se asume que cualquier configuración

no contenida en el archivo es la predeterminada.

La opción restore restaura la configuración.

-ConfigPath Opcional. Especifica la ruta y el nombre de archivo del archivo principal para guardar la configuración.